人工智能从20世纪50年代开始,经历了60年起伏的发展历程。其中,AI共经历了2次发展的春天和冬天,现在正在经历第3个春天,即以数据为驱动力的深度学习。谷歌的AlphaGo、AlphaZero、AlphaFold是很好的标志性产品。

佩德罗多明戈斯曾总结了AI的五大流派,包括符号、进化学派、类比学派、贝叶斯学派和连接机制。未来AI的发展趋势最大的可能是借各种流派之长创造新的AI算法,既包含逻辑符号也有数据和知识,还要借鉴人类的进化和大脑的特点。所以,当前无论是科学研究还是产业发展,都在思考下一轮AI的突破点在什么地方。

算力需求飞速增长的瓶颈

对深度学习来说,半导体与芯片架构领域的进步是不可或缺的发展动力。谷歌公司的杰夫狄恩曾说过:“数据+算法+算力=数据+100×算力”。也就是说,他认为在数据、算法和算力三大因素中,算力占据着绝对的主导地位,算法则相对来说没有那么重要。

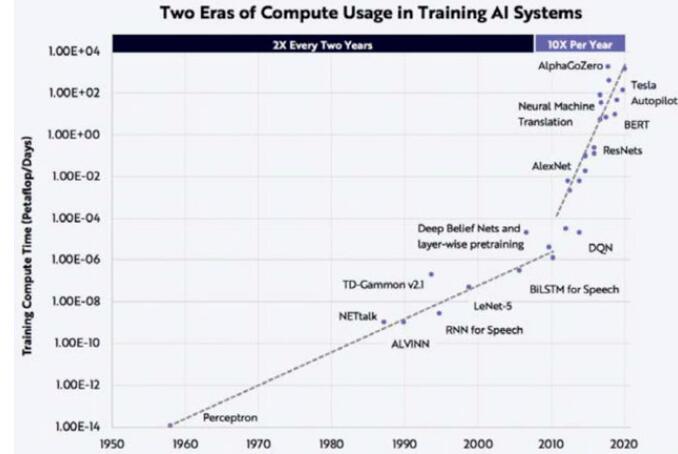

随着时代的发展,深度学习在训练过程中产生的计算量可以分成两个阶段:在深度学习发展的初期阶段,训练产生的计算量的增长速率相对较慢;近10年间,计算量以每年10倍的速率增长,远远超过摩尔定律每18~24个月提高2倍的增长速率。

深度学习训练过程中计算量需求的发展

以OpenAI发布的预训练模型GPT为例,来说明近几年来机器学习领域对算力需求的飞速增长。2018年6月发布的GPT-1是在约5GB的文本上进行无监督训练,针对具体任务,在小的有监督数据集上做微调,得到包含1.1亿参数的预训练模型;而2019年2月发布的GPT-2则是在约40GB文本上进行无监督训练,得到具有15亿参数的预训练模型;而2020年5月公布的GPT-3则是在499Btokens(令牌)的数据基础上训练,得到包含1750亿参数的模型。在不到2年的时间内,模型参数从1.1亿的规模增长至1750亿,而单次训练GPT-3就需要花费1200万美元,模型在飞速发展的同时,带来的是巨大的算力要求和高成本的代价。

传统计算与通讯范式的瓶颈

人工智能领域对算力的需求驱动了新算力的发展。要想谋求更高效率的计算,就需要回到计算和通讯领域最基本的理论和范式。在过去的几十年间,涌现出了许许多多的定律和体系,而其中有三个定律和体系被视为计算与通讯范式的根本。

第一个是香农定律(ShannonTheroy)。香农是信息论的奠基者,他引入了信息熵的概念,为数字通信奠定了基矗其实香农定律定义了三个极限,分别为无损压缩极限E、信道传输极限C、有损压缩极限R(D)。目前,我们已经接近这些极限。

第二个是冯诺伊曼架构(VonneumannStructure)。在冯诺伊曼架构中,计算机由运算器、控制器、存储器、输入设备和输出设备5个基本部分组成,具有程序存储、共享数据、顺序执行的特点。冯诺伊曼架构简单且漂亮,是图灵机的优秀范例,至今仍被广泛地应用。然而,冯诺伊曼架构的设计构成了运算器和存储器间的瓶颈,这对深度学习的发展造成了一定的限制。

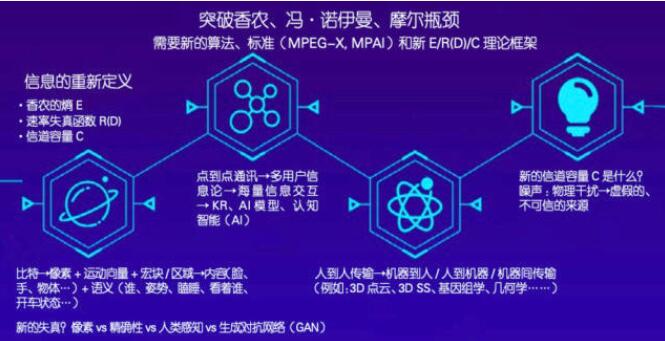

信息论的研究方向

第三个是摩尔定律(Moore‘sLaw)。戈登摩尔(GordonMoore)总结认为,集成电路上可以容纳的晶体管数目大约在18个月左右便会增加一倍。而现在晶体管数目的增长越来越慢,摩尔定律逐步趋向于饱和阶段,而我们对计算能力的需求却飞速提升,不断提升的算力需求与芯片技术发展趋缓的矛盾日趋显现。

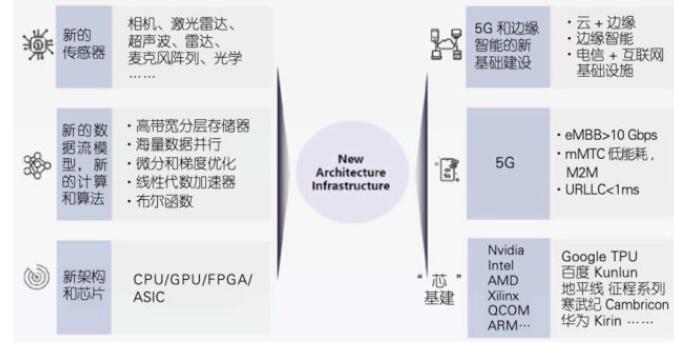

计算体系与通讯架构的革新展望

在过去的60年里,这三个基本理论在计算和通讯领域建立了决定性的基础,然而日趋逼近的极限也使得当前AI技术的发展逐步接近瓶颈。为了避免技术的停滞不前,产业界或许可以从以下三个方面做出一些突破和革新。

首先,对信息重新定义。香农于上世纪40年代对信息熵、速率失真函数R(D)和信道容量C做出了定义,而这些定义是基于比特的基础实现的。以视频图像举例,过去我们一直采用比特来描述信息;后来我们从数字的层面使用像素、运动向量、宏块(macroblock)和区域(regions)结合的方式来描述图像;之后我们上升到从内容层面来描述图像,比如一个身体部位是脸部还是手部等;现在我们对图像的描述上升到语义层面,比如“是谁”“在做什么动作”“是否在睡觉”“眼睛在看什么”等,这些问题从语义的层面描述了图像传达的信息。当信息的描述方式发生变化时,熵的概念也发生了变化。比方说,过去我们用比特的形式来描述图像失真现象,而现在我们用生成对抗网络(GenerativeAdversarialNetworks,GAN)生成图像,用肉眼来看GAN输入的图片和生成的图像几乎是一致的,但是从比特层面来比较,会发现二者十分不同。因此,如何从语义、特征和内容的角度来定义熵与速率失真函数是我们未来需要研究的问题。另外,香农理论从最开始的点到点通讯,扩展到后来的多用户信息论。但是在当下的互联网时代,面对海量的交互信息,部分香农理论已不再适用,学术界却没有提出一个新的完善的理论。过去的信息更多的是人与人之间的传输,而现在的信息则更多地面向机器,比如3DPointCloud、3DSS、Genomics、Geometry等,所以我们需要新的算法和新的标准。

计算体系与通讯架构的研究方向

第二,我们需要新的计算范式。包括量子计算、类脑计算和生物计算等在内的新的计算范式能够为计算瓶颈提供解决途径。

第三,我们需要新的计算体系和通讯架构突破冯诺伊曼体系架构的限制。首先,我们需要新的传感器、新的数据流架构和计算模式,以及高速的存储,这些都与传统的冯诺伊曼架构不同。我们还需要新的通讯架构,即5G技术和边缘计算。5G技术首次在应用层上实现了“三网合一”,比提升传输的速度更加有效。此外,5G技术更好地解决了延时问题并带来了新的应用,如百度的阿波罗项目中有一个服务叫做“云代驾”,通过5G技术让远程的安全操作员实时了解车辆所处的环境与状态,在自动驾驶无法完成的场景下接管车辆,完成远程协助。但3G和4G网络的延迟使得“云代驾”模式无法成为现实,必须通过5G网络来解决延迟问题。很多人认为,当前的5G技术在能耗和覆盖率等方面还没有达到预期,但任何新技术的发展都需要时间,相信在未来的三五年后,5G技术能够为用户、工业和产业界带来巨大的变革。

芯片的升级对产业界的作用是显著的,近年来国内有许多公司在芯片领域有所成就。以百度的昆仑AI芯片为例,第一代昆仑芯片采用14nm先进工艺,2.5D封装,使用HBM内存,可以达到512GB/s的带宽。而预计于2021年量产的第二代昆仑芯片,采用7nm先进工艺,性能是第一代昆仑芯片的3倍,同时耗能减少,具备了大规模片间互联的能力,进步显著。

版权及免责声明:凡本网所属版权作品,转载时须获得授权并注明来源“物联之家 - 物联观察新视角,国内领先科技门户”,违者本网将保留追究其相关法律责任的权力。凡转载文章,不代表本网观点和立场。

延伸阅读

版权所有:物联之家 - 物联观察新视角,国内领先科技门户