苹果实况文本功能对比测试

前天凌晨,苹果带来了近些年最幻灭的一次系统更新。没有息屏显示、没有新的UI设计,没有什么惊艳的黑科技,只有大量安卓用户耳熟能详的“新功能”。难怪网友评价:比起全新的系统版本,iOS 15更像是iOS 14的优化版本,叫做iOS 14.8可能更适合。

不过,虽然iOS 15带来的功能更新令人失望,但仍有部分网友毫不犹豫地选择了尝鲜Beta版。根据实际体验,iOS 15 Beta版本BUG不少,唯一能拿得出手的更新内容Facetime SharePlay还面临着无法使用的窘况。现在看来,实况文本(Live Text)功能,无疑是这次平平无奇的iOS 15 Beta版本更新中最实用的新功能了。

图像识别,人人都有

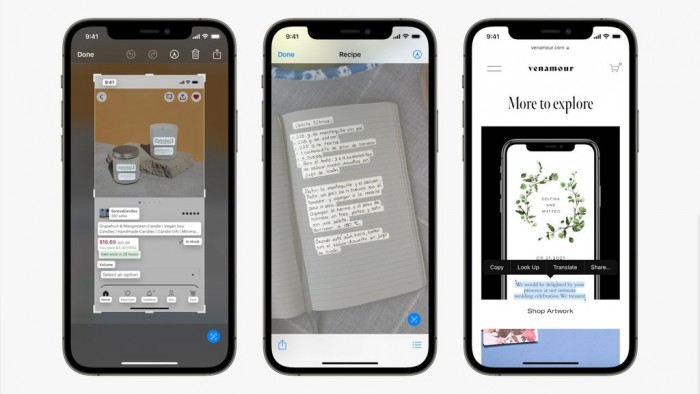

首先介绍一下,所谓的「实况文本」,其实就是可以在iOS相机应用中启动的文字识别功能。无论是相机正在拍摄的画面、已经拍好的照片,还是手机屏幕截图、网页图片,都可以通过该功能自动识别并转录照片中的文字,支持复制、粘贴、查找及翻译,实现照片中的文本提取和快速应用。

当然,类似的图像识别功能早已在众多安卓品牌的手机上实现。无论是谷歌在四年前推出的Google Lens应用,还是各家国产手机厂商自带的“扫一扫”应用,基本都能轻松实现文字提取。借此机会,小雷今天就来为读者们解惑释疑:苹果的「实况文本」,究竟和其他同类功能有何不同?

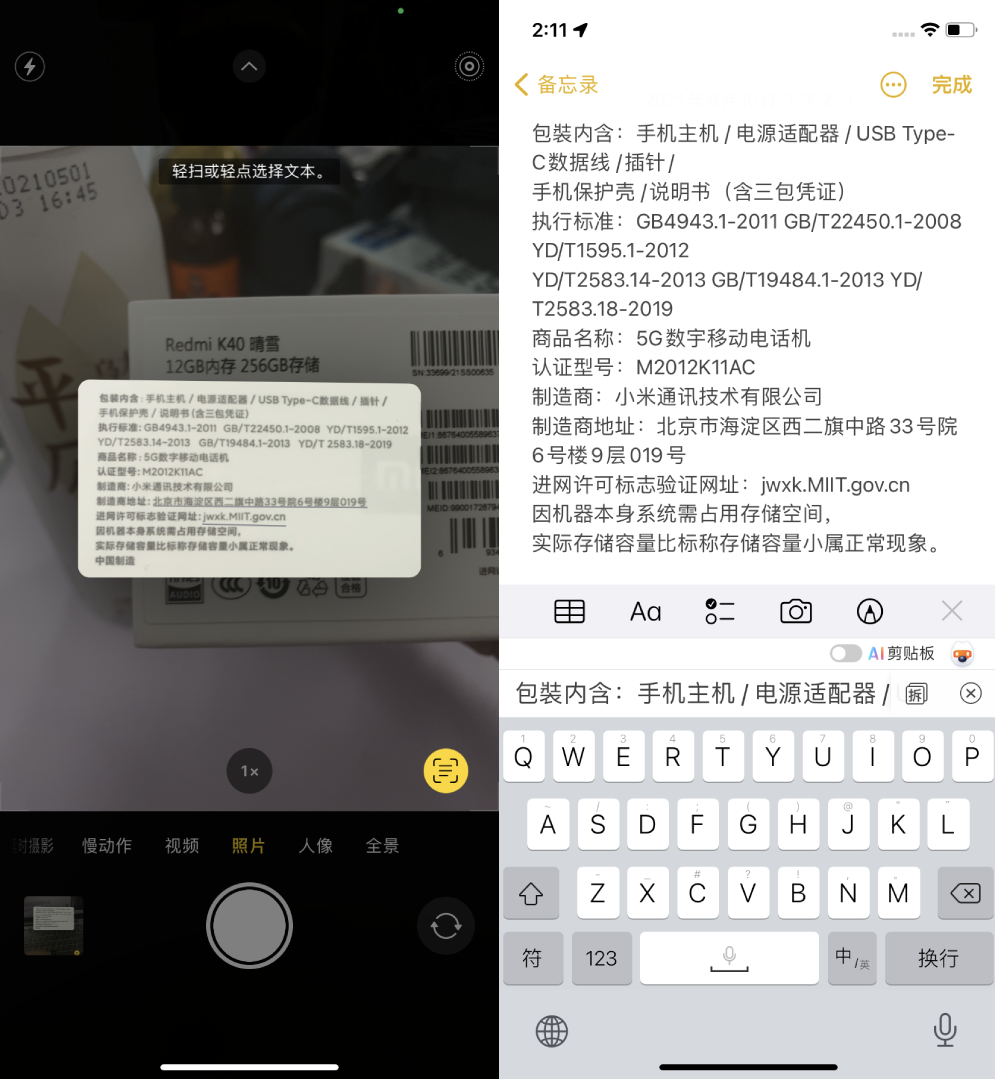

首先,苹果的「实况文本」是整合在相机里面的,用户可以打开相机、打开相册或是使用备忘录里的「来自相机的文本」选择使用该功能。实测iPhone可以自动识别出画面中的文字,点击按钮即可提取自己想要的文字,还可以对提取出来的文字进行查询、翻译、拷贝、共享等操作。从结果来看,苹果「实况文本」对印刷体的文本识别率还是很不错的,对中文手写体的文本识别率就不太理想了,需要改进。

(印刷体)

(手写体)

此外,苹果提取的「实况文本」还会自动识别号码、网址和地址并生成超链接。点击网址,即可跳转对应网站;点击地址,就会打开对应地址的地图信息;点击号码,则可以选择发送短信、添加到联系人,用起来还是挺方便的。

(网址、地址)

(号码)

接着,我们来尝试一下谷歌原生的Google Lens应用。文字识别方面,用户直接在取景框点击对应内容,即可提取自己想要的文字。实际体验下来,Goolgle Lens对印刷体和手写体的文本识别率出人意料地优秀,谷歌研究多年的文字识别技术确实不是虚的。

(印刷体)

(手写体)

此外,Google Lens同样会自动识别网址、号码等信息。被识别出来的网址,可以通过点击下方的网页选项完成跳转;被识别出来的号码,更是可以直接拨打给对方。此外,在面对比较复杂的大段图文内容时,Google Lens基本也能实现即拍即取,文本识别率相当不错。

最后,我们来试试国产厂商自带的文本提取功能。以小雷常用的小米10为例,小米相机、「传送门」和「扫一扫」里的文档功能,均可以对图片进行文本识别。实际体验下来,小米相机对印刷体和手写体的文本识别率都还不错,作为文本识别功能而言绝对是合格的。

值得注意的是,小米「扫一扫」本身并没有识别网址、号码等特殊信息的能力,所有图片扫出来都是可以编辑的无格式文本。用户当然可以自己复制网址、地址,然后打开对应App进行搜索,就是使用起来比较繁琐。

经过测试,我们可以大致看出这三款产品之间的功能差异。文本识别方面,谷歌的Google Lens识别率毋庸置疑地排在榜首,小米的三种文本识别功能虽然各有差异,但是识别率排在第二还是没什么问题的,苹果的「实况文本」在这方面还可以多加改进。操作方面,三款产品均可通过实时拍照进行文字提取,操作起来都很直观。功能方面,没有识别能力的小米要稍逊一筹,而谷歌的搜索识别能力要比苹果显得更加方便好用。

谷歌能在这方面大获全胜,自然是有其原因的。早在2010年,谷歌文档就已经加入了OCR文字识别功能,支持用户将PDF档案或图片档案中的文字转换为可编辑的文本,而Google Lens在2017年就已经与大家见面了,两者之间的经验差距是巨大的,需要时间去弥补。

什么让苹果够“苹果”?

作为一个全新推出的功能,苹果的「实况文本」确实存在诸多不足之处。首先,目前Google Lens支持上百种语言识别,而苹果「实况文本」只支持七种语言,两者泛用性完全不对等。其次,「实况文本」的手写文字识别率确实比较微妙,还有很大的提升空间。

当然,该功能也有其优势所在。首先,谷歌的GoogleLens是需要用户联网交换数据的,在国内想要使用谷歌服务可不是一件容易的事。国内厂商的图像识别功能倒是可以正常联网,但是在没有网络的情况下也就运作不了了。作为对比,「实况文本」功能是基于采用机载处理的“深层神经网络”,而不是基于云计算的方法。换句话说,该功能在没有联网的情况下也可以正常使用。

其次,目前手机上的文本识别功能大多都以独立应用的形式存在着,例如谷歌自研的应用GoogleLens、三星的图像识别软件Bixby Vision、小米的「扫一扫」、OPPO的「Breeno识屏」等。和它们不同,苹果的「实况文本」功能是内建在相机里面的,而所有的文本都是在用户拍照时自动捕捉的,用户不必启动单独的应用程序就能使用对应功能。

再次,虽然是后来者,但是苹果的生态结合得更加紧密。在WWDC 2021上,苹果公布了全新升级的「聚焦搜索」功能。现在「聚焦搜索」通过智能技术,可以根据定位信息、人物、场景或物品来搜索图片,用户只要下拉菜单栏,输入关键词,就可以轻松搜索到所有包含该文字的图片。

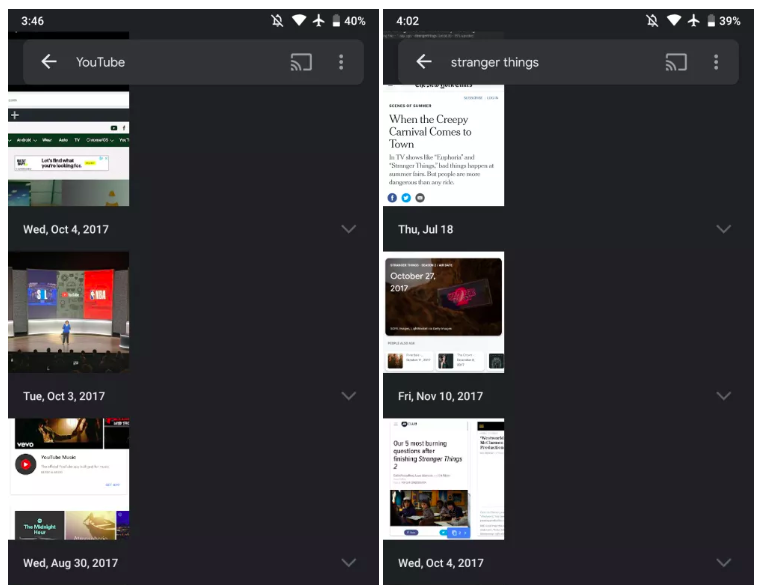

一直以来,安卓厂商最为人诟病的就是生态割裂。举个例子,小雷在小米10上能找到三个图像识别功能,三者之间互不关联,和小米自身的全局搜索也没有产生任何联系,都是独立存在的功能。2019年,谷歌曾经试过将Google Lens和Google Photos相结合,让使用者可以用文字搜索到想要的照片。问题是,市面上很少会有大厂会使用谷歌自家的相簿,生态也就无从谈起。

(Google Photo的图文搜索)

有的人觉得,苹果是不是已经黔驴技穷了?事实上,手机厂商相互「借鉴」不是从现在才开始的,在一个行业中学习对手并且取长补短并不是什么坏事,都是为了更好地服务用户。小雷认为,好的系统就应该积极倾听用户的呼声,及时推出高效易用的功能。

总的来说,「实况文本」功能还是很实用的。该功能的推出,让果粉明白自己手机上的相机并不是只能用来拍照的。利用「实况文本」功能,苹果相机现在可以随时随地呈现信息。用户只需对准相机,就可以获知身边环境的上千万个单词、短语、位置和事物,更好地浏览周围的世界。

此外,在「实况文本」的基础上,苹果还加入了全新的「视觉查找」功能。该功能和「实况文本」相辅相成,可以自动识别照片中的地标、自然、书籍以及宠物信息,并进行突出显示,帮助用户获得更多相关的信息。

融洽的生态,为用户带来了更加优秀的体验。设想一下,当我们走在国外陌生的街道上,只要掏出手机对着素不相识的文字,相机就可以为我们自动进行翻译;当我们站在某栋地标建筑面前,打开相机,就可以了解关于这个建筑物的相关信息。这样的体验,可以给我们带来很多便利。

小雷认为,在苹果的启发之下,现在已经拥有类似功能的安卓厂商也会开始尝试将其整合到生态里面,让用户的体验不再割裂。这般增强现实的体验,或许离我们已经不远了。

版权及免责声明:凡本网所属版权作品,转载时须获得授权并注明来源“物联之家 - 物联观察新视角,国内领先科技门户”,违者本网将保留追究其相关法律责任的权力。凡转载文章,不代表本网观点和立场。

延伸阅读

版权所有:物联之家 - 物联观察新视角,国内领先科技门户